الاقتصادي- رصد

شراكة تثير المخاوف

العالم يشهد تحوّلًا نوعيًا في دور الذكاء الاصطناعي؛ فبعد أن كان مجرد أداة مساعدة، أصبح اليوم شريكًا في صنع القرار. هذا التطور يفتح آفاقًا واسعة لتحسين الكفاءة والشفافية، لكنه يثير أيضًا مخاطر الاعتماد المفرط على الخوارزميات في قرارات مصيرية تمس الإنسان والمجتمع.

لم يعد الذكاء الاصطناعي مجرد أداة تقنية مساعدة على إنجاز المهام الروتينية أو تسريع العمليات الحسابية المعقدة. لقد تجاوز هذه المرحلة ليصبح اليوم شريكًا فعليًا في عملية صنع القرار داخل المؤسسات، سواء في الإعلام أو الاقتصاد أو حتى السياسة. هذا التحول الجذري يثير أسئلة عميقة حول طبيعة السلطة، وحدود المسؤولية، ومخاطر الاعتماد المفرط على الخوارزميات في قرارات مصيرية تمس حياة الأفراد والمجتمعات.

من التحرير إلى التوجيه

الأكثر إثارة للجدل هو دخول الذكاء الاصطناعي إلى ميدان السياسة وصنع القرار السيادي. الحكومات باتت تستخدمه في تحليل البيانات الأمنية، ورصد التهديدات، وحتى في صياغة السياسات العامة

سأبدأ بالمهنة التي أمارسها؛ في غرف الأخبار، لم يعد الذكاء الاصطناعي مجرد أداة لتصحيح الأخطاء اللغوية أو اقتراح عناوين جذابة، بل أصبح قادرًا على تحليل اتجاهات الرأي العام، ورصد التفاعلات على شبكات التواصل الاجتماعي، واقتراح زوايا تغطية تتماشى مع اهتمامات الجمهور. بعض المؤسسات الإعلامية باتت تعتمد على الخوارزميات لتحديد أولويات النشر، بل وحتى لتخصيص الأخبار وفقًا لملف كل قارئ.

هذا التطور يفتح الباب أمام فرص هائلة: تحسين الكفاءة، تقليل التكاليف، وتقديم محتوى أكثر قربًا من اهتمامات الجمهور. لكنه في الوقت نفسه يطرح إشكالية خطيرة: من يحدد ما هو “مهم” وما هو “ثانوي”؟ إذا كانت الخوارزميات هي التي تتحكم في ترتيب الأخبار، فإنها قد تكرّس الانحيازات المضمرة في بياناتها، أو تُعيد إنتاج الصور النمطية، أو تُقصي قضايا جوهرية لأنها لا تحظى بتفاعل رقمي كافٍ. وهنا يصبح الذكاء الاصطناعي ليس مجرد مساعد، بل محررًا خفيًا يوجّه الرأي العام.

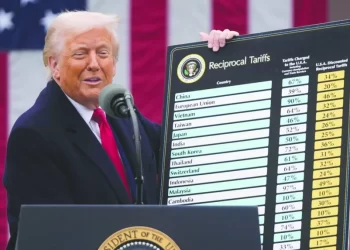

في عالم المال والأعمال تحوّل الذكاء الاصطناعي إلى لاعب رئيسي. صناديق الاستثمار الكبرى تعتمد على أنظمة تداول آلي تتخذ قرارات شراء وبيع في أجزاء من الثانية، بناءً على تحليل ملايين البيانات في الوقت الفعلي. شركات كبرى تستخدم الذكاء الاصطناعي لتوقّع سلوك المستهلكين، وضبط الأسعار، وإدارة سلاسل التوريد.

الميزة هنا واضحة: قدرة غير مسبوقة على التنبؤ وتقليل المخاطر وتحقيق أرباح أعلى. لكن الوجه الآخر للعملة يتمثل في هشاشة النظام أمام “الاعتماد المفرط”. فالأزمة المالية العالمية عام 2008 أظهرت كيف يمكن للنماذج الرياضية أن تُضلّل الأسواق إذا بُنيت على افتراضات خاطئة. واليوم، إذا كانت الخوارزميات هي التي تدير مليارات الدولارات، فإن أي خطأ في البرمجة أو انحياز في البيانات قد يؤدي إلى انهيارات كارثية.

فاعل إستراتيجي

كيف نستفيد من قدرات الذكاء الاصطناعي في تحسين الكفاءة والشفافية دون أن نفقد السيطرة على القرارات المصيرية؟

الأكثر إثارة للجدل هو دخول الذكاء الاصطناعي إلى ميدان السياسة وصنع القرار السيادي. الحكومات باتت تستخدمه في تحليل البيانات الأمنية، ورصد التهديدات، وحتى في صياغة السياسات العامة. بعض الدول تختبر أنظمة تعتمد على الذكاء الاصطناعي لتقييم المخاطر الجيوسياسية أو لتوجيه الحملات الانتخابية.

الفرصة هنا تكمن في تعزيز الشفافية: يمكن للذكاء الاصطناعي أن يكشف الفساد عبر تحليل أنماط الصفقات، أو أن يقترح سياسات أكثر عدالة بناءً على بيانات موضوعية. لكن الخطر يكمن في “إلغاء البعد الإنساني”. السياسة ليست مجرد أرقام، بل هي أيضًا قيم ومبادئ ومصالح متعارضة. إذا تحوّل القرار السياسي إلى مجرد مخرجات خوارزمية، فإننا نخاطر بفقدان البوصلة الأخلاقية التي تميّز بين ما هو قانوني وما هو عادل.

بين الكفاءة والشفافية من جهة، والمخاطر من جهة أخرى التحول من “مساعد ذكي” إلى “شريك في صنع القرار” يضع المؤسسات أمام معادلة دقيقة: كيف نستفيد من قدرات الذكاء الاصطناعي في تحسين الكفاءة والشفافية، دون أن نفقد السيطرة البشرية على القرارات المصيرية؟

من جهة، الذكاء الاصطناعي قادر على تقليل الأخطاء البشرية، وتقديم رؤى مبنية على تحليل ضخم للبيانات، وتسريع عملية اتخاذ القرار. في عالم الإعلام، يمكنه أن يفضح الأخبار الزائفة بسرعة. في الاقتصاد، يمكنه أن يتنبأ بالأزمات قبل وقوعها. في السياسة، يمكنه أن يقدّم بدائل مدروسة لصانعي القرار.

لكن من جهة أخرى، الاعتماد المفرط على الخوارزميات قد يؤدي إلى “تجريد” القرارات من بعدها الإنساني. الخوارزميات لا تحس بالألم ولا تعرف معنى العدالة أو الكرامة. هي تحسب الاحتمالات وتنتج توصيات، لكنها لا تتحمل المسؤولية الأخلاقية. وإذا أخطأت، فمن يحاسب؟ المبرمج؟ المؤسسة؟ أم الخوارزمية نفسها؟

نحو شراكة متوازنة

في عالم المال والأعمال تحوّل الذكاء الاصطناعي إلى لاعب رئيسي.. شركات كبرى تستخدم الذكاء الاصطناعي لتوقّع سلوك المستهلكين، وضبط الأسعار، وإدارة سلاسل التوريد

لهذا السبب يزداد الحديث اليوم عن ضرورة وضع أطر واضحة لحوكمة الذكاء الاصطناعي. هذه الحوكمة لا تعني فقط سنّ قوانين، بل أيضًا تطوير ثقافة مؤسسية جديدة تعترف بأن الذكاء الاصطناعي شريك، لكن ليس بديلاً عن الإنسان.

في الإعلام، يجب أن تظل الكلمة الأخيرة للمحرر البشري الذي يوازن بين ما هو مهم وما هو صحيح. في الاقتصاد، يجب أن تكون هناك آليات رقابة تضمن أن الخوارزميات لا تخلق فقاعات مالية أو تمييزًا ضد فئات معينة من المستهلكين. في السياسة، يجب أن يظل القرار النهائي بيد القادة المنتخبين، الذين يتحملون المسؤولية أمام شعوبهم.

الذكاء الاصطناعي ليس عدوًا ولا مخلّصًا. هو أداة قوية يمكن أن تكون شريكًا فعّالًا إذا أُحسن استخدامها. التحدي يكمن في بناء شراكة متوازنة: نستفيد من قدراته في التحليل والتنبؤ، لكننا لا نتخلى عن البعد الإنساني في القرار.

إن مستقبل المؤسسات لن يُقاس فقط بمدى تبنيها للتكنولوجيا، بل أيضًا بقدرتها على دمج الذكاء الاصطناعي في منظومة قيمية وأخلاقية تحافظ على إنسانية القرار. فالتاريخ يعلّمنا أن كل ثورة تقنية تحمل وعودًا ومخاطر، وأن النجاح يكمن في القدرة على الموازنة بينهما.

من “مساعد ذكي” إلى “شريك في صنع القرار”، هذه هي الرحلة التي قطعها الذكاء الاصطناعي في زمن قصير. الرحلة لم تنتهِ بعد، بل هي في بدايتها. والمؤسسات التي ستنجح في المستقبل هي تلك التي تدرك أن الذكاء الاصطناعي ليس مجرد برنامج، بل قوة إستراتيجية تجب إدارتها بحكمة.

إن السؤال الحقيقي ليس: هل نسمح للذكاء الاصطناعي باتخاذ القرارات؟ بل: كيف نضمن أن هذه القرارات، مهما كانت دقيقة وسريعة، تظل في خدمة الإنسان، لا العكس؟

علي قاسم

المصدر: العرب